티스토리 뷰

MachineLearning

[MachineLearning] Error - mean squared error(MSE), cross entropy error(CEE)

SweetDev 2021. 7. 12. 19:221. Mean Squared Error(MSE)

2. Cross Entropy Error(CEE)

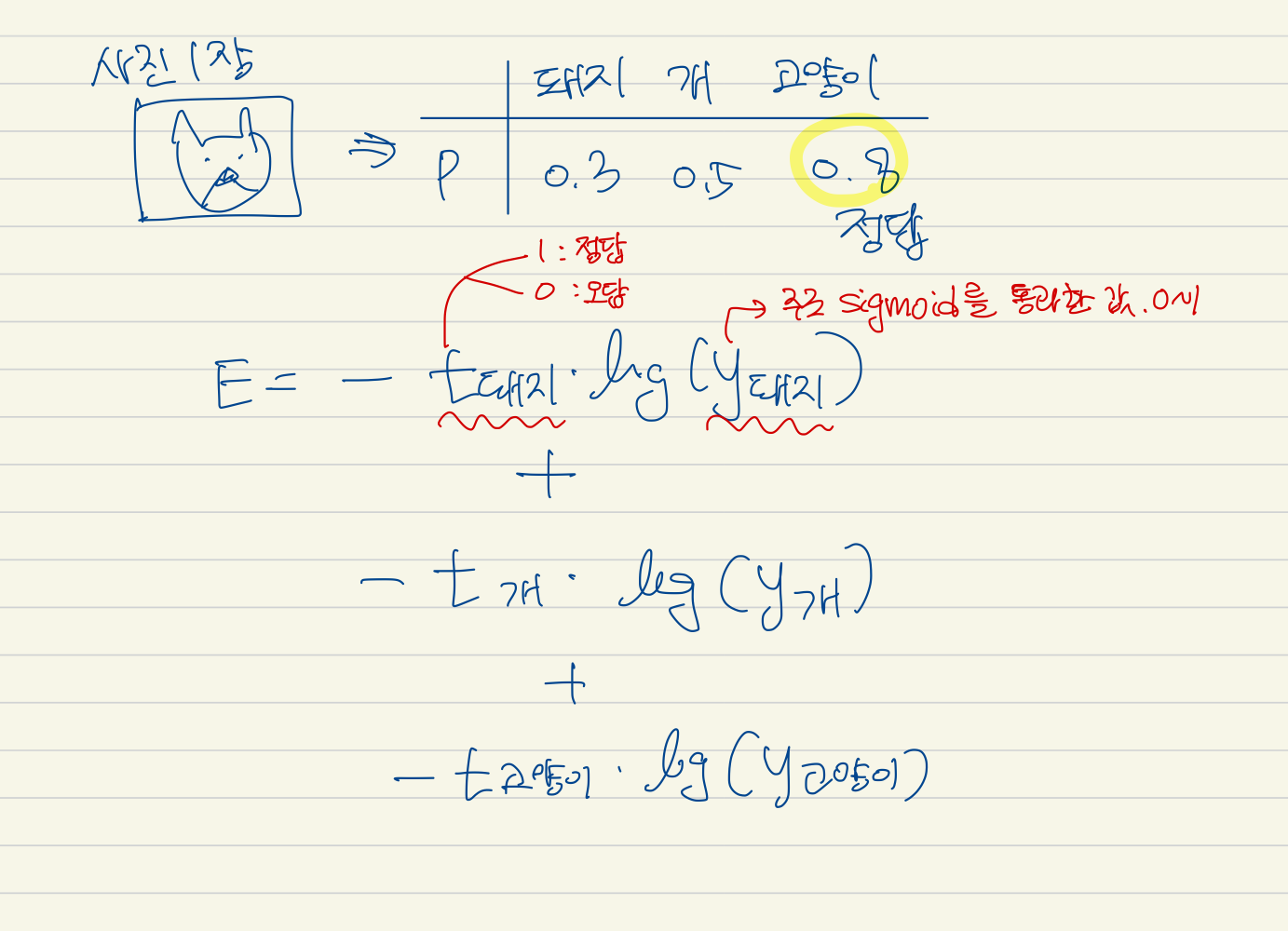

먼저,이 에러는 하나하나의 데이터에 대한 에러 값이다.

softmax를 통과한 값을 확률로 쓴다.

softmax를 생각해보면, 이렇게 생겼다.

k = e^a / (e^a + e^b + e^c)

t는 정답이면 1이고, 오답이면 0이다. sigma를 쓰지만 정답인 값의 log만 쓰이는 셈이다.

one-hot encoding한 y(신경망 출력), t(정답 레이블) 에 대해서,

E = -sum(t_k * log(y_k))

근데 one-hot encoding 해줬으니까 0<= y_k <= 1인데, log(0) = -∞, log(1) = 0이니까 E에다가 -를 곱해서 부호를 바꿔줬다.

말이 시그마긴 한데 결국 하나만 살아남는다!

-log(x)의 그래프를 생각해보면 예측값이 1에 가까우면 오차가 작아지는 형식이다.

'MachineLearning' 카테고리의 다른 글

| [Python][numpy] flatnonzero, dot, reshape, arange, zeros_like, max (0) | 2021.07.19 |

|---|---|

| [MachineLearning] Activation Function - Step, Sigmoid, ReLU (0) | 2021.07.13 |

| [MachineLearning] output layer function - identity function, softmax function (0) | 2021.07.09 |

| [MachineLearning] perceptron (0) | 2021.07.05 |

| [PyTorch] 기본 벡터 연산하기 (0) | 2021.06.22 |