티스토리 뷰

MachineLearning

[MachineLearning] Multiclass SVM loss, loss function - regularization

SweetDev 2021. 7. 26. 16:37출처 : Stanford cs231n

https://www.youtube.com/watch?v=h7iBpEHGVNc&list=PL3FW7Lu3i5JvHM8ljYj-zLfQRF3EO8sYv&index=3

0. SVM ( Support Vector Machine ) 이란?

http://hleecaster.com/ml-svm-concept/

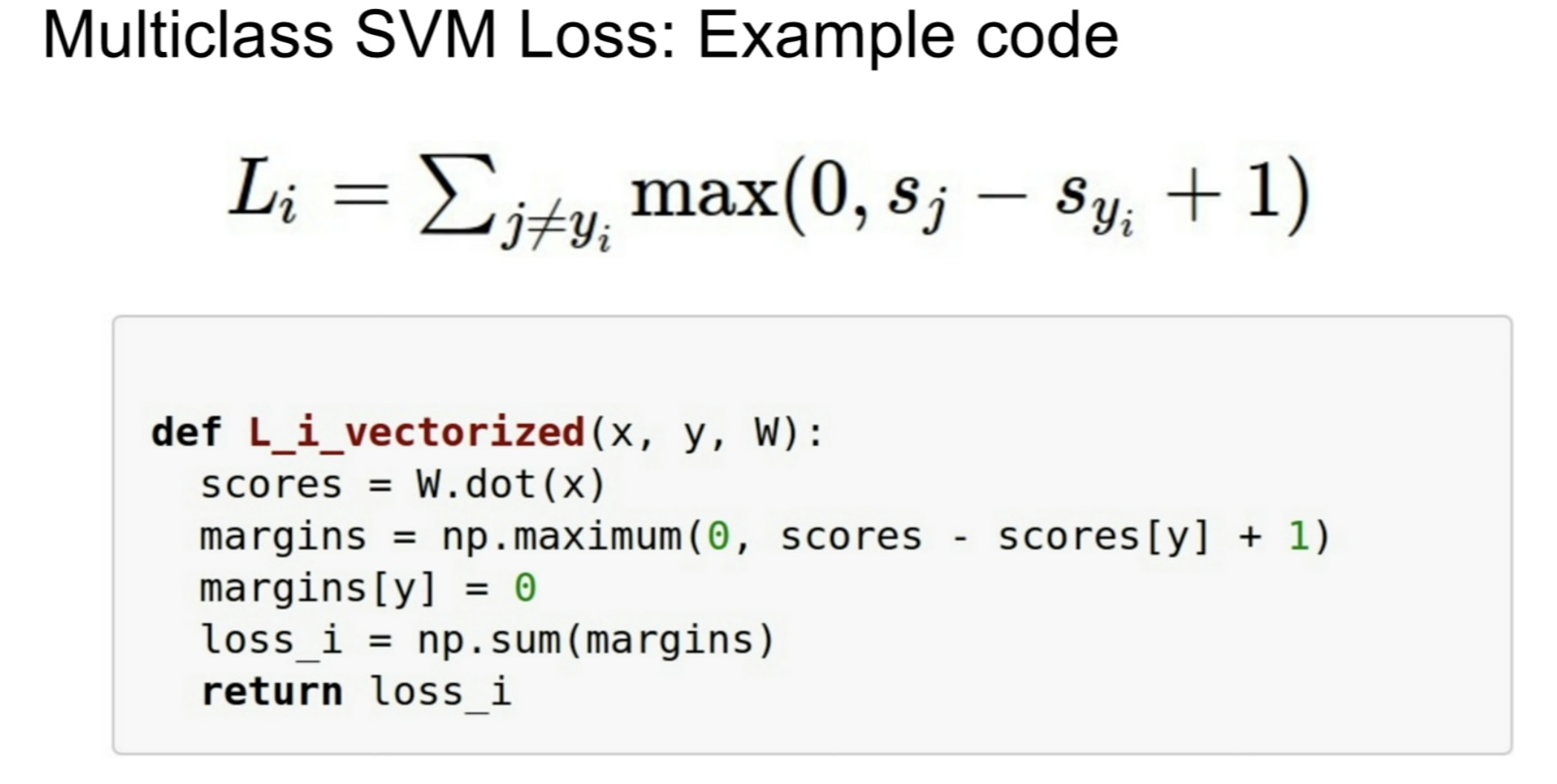

1. Multiclass SVM loss

코드는 다음과 같이 벡터화해서 작성할 수 있다.

2. Loss함수의 regularization

처음과 같이 작성하니 과도하게 training set에 최적화되는 문제가 생겼다. 파란색 선처럼!

그래서 람다 값을 추가하는데 이를 Regularization이라고 한다.

그래서 Loss함수는 이제 Data Loss와 Regularization Loss의 합의 값이 되게 된다.

Regularization Loss은 hyperparameter인 람다와 R(W)의 곱으로 결정된다.

R(W)는 어떤 식일까?

'MachineLearning' 카테고리의 다른 글

| [MachineLearning] chain rule, backpropagation (0) | 2021.08.12 |

|---|---|

| [MachineLearning] Lp-Norm 이해하기 (0) | 2021.07.26 |

| [Python][numpy] flatnonzero, dot, reshape, arange, zeros_like, max (0) | 2021.07.19 |

| [MachineLearning] Activation Function - Step, Sigmoid, ReLU (0) | 2021.07.13 |

| [MachineLearning] Error - mean squared error(MSE), cross entropy error(CEE) (0) | 2021.07.12 |